Robot.txt SEO: najbolji primjeri iz prakse, uobičajeni problemi i rješenja

U ovom postu na blogu raspravljat ćemo o svemu što trebate znati o robots.txt, od toga što je datoteka robots.txt u SEO-u do najboljih praksi i ispravnog načina rješavanja uobičajenih problema.

Od vremena učitavanja stranice do odgovarajućih naslovnih oznaka, postoje mnogi signali rangiranja u kojima tehnički odrađen SEO može pomoći. Ali jeste li znali da se jedna od najvažnijih datoteka za SEO vaše web stranice također nalazi na vašem poslužitelju?

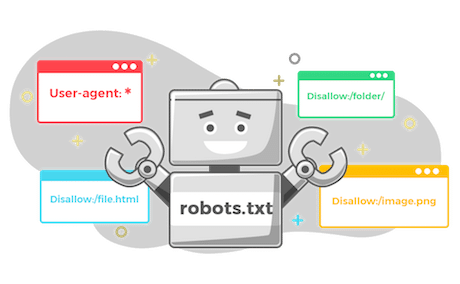

Datoteka robots.txt kod je koji alatima za indeksiranje weba govori koje stranice na vašoj web stranici mogu indeksirati, a koje ne. Ovo se možda ne čini kao velika stvar, ali ako vaša datoteka robots.txt nije ispravno konfigurirana, može imati ozbiljan negativan učinak na SEO vaše web stranice.Što je datoteka robots.txt i zašto je važna za SEO?

Datoteka Robots.txt je datoteka koja se nalazi na vašem poslužitelju i govori web pretraživačima kojim stranicama mogu, a kojim ne mogu pristupiti. Ako alat za indeksiranje weba pokuša indeksirati stranicu koja je blokirana u datoteci robots.txt, to će se smatrati pogreškom (error) 404.

Iako pogreška 404 neće naštetiti rangiranju vaše web stranice, ona se i dalje smatra pogreškom. A previše pogrešaka na vašem web-mjestu može dovesti do sporijeg indeksiranja što na kraju može naštetiti vašem rangiranju zbog smanjenog indeksiranja.

Ako vaša web stranica ima puno stranica koje blokira datoteka robots.txt, to također može dovesti do uzaludnog proračuna za indeksiranje. Proračun indeksiranja je broj stranica koje će Google indeksirati na vašoj web stranici tijekom svakog posjeta.

Još jedan razlog zašto su robots.txt datoteke važne u SEO-u je taj što vam daju veću kontrolu nad načinom na koji Googlebot indeksira vašu web stranicu. Ako imate web stranicu s puno stranica, možda biste trebali blokirati indeksiranje određenih stranica kako ne bi preopteretile alate za indeksiranje tražilice i naštetile vašem rangiranju.

Ako imate blog sa stotinama postova, možda biste trebali dopustiti Googleu da indeksira samo vaše najnovije članke. Ako imate web-mjesto za e-trgovinu s mnogo stranica proizvoda, možda biste trebali dopustiti Googleu da indeksira samo vaše stranice glavne kategorije.

Ispravna konfiguracija vaše datoteke robots.txt može vam pomoći u kontroli načina na koji Googlebot indeksira vašu web stranicu, što na kraju može poboljšati vaše rangiranje.

Što Google kaže o najboljim primjerima iz prakse datoteke robots.txt

Sada kada smo razjasnili zašto su robots.txt datoteke važne u SEO-u, razgovarajmo o nekim najboljim praksama koje preporučuje Google.

Napravite datoteku pod nazivom robots.txt

Prvi korak je stvaranje datoteke pod nazivom robots.txt . Ovu datoteku treba smjestiti u korijenski direktorij vaše web stranice – direktorij najviše razine koji sadrži sve ostale datoteke i direktorije na vašoj web stranici.

Evo primjera ispravnog postavljanja datoteke robots.txt: na web stranici apple.com, korijenski direktorij bi bio apple.com/.

Datoteku robots.txt možete izraditi s bilo kojim uređivačem teksta, ali mnogi CMS-ovi poput WordPressa automatski će je stvoriti za vas.

Dodajte pravila u datoteku robots.txt

Nakon što ste izradili datoteku robots.txt, sljedeći korak je dodavanje pravila. Ova će pravila reći web pretraživačima kojim stranicama mogu, a kojim ne mogu pristupiti.

Postoje dvije vrste sintakse robot.txt koje možete dodati: Dopusti i Zabrani.

Pravila dopuštanja reći će alatima za indeksiranje da im je dopušteno indeksirati određenu stranicu.

Pravila zabrane reći će alatima za indeksiranje da im nije dopušteno indeksirati određenu stranicu.

Na primjer, ako želite dopustiti alatima za indeksiranje weba da indeksiraju vašu početnu stranicu, dodajte sljedeće pravilo: Allow: /

Ako želite onemogućiti web indeksiranju indeksiranje određene poddomene ili podmape na vašem blogu, koristite: Disallow: /

Učitajte datoteku robots.txt na svoju stranicu

Nakon što ste dodali pravila svojoj datoteci robots.txt, sljedeći korak je da je postavite na svoju web stranicu. To možete učiniti pomoću FTP klijenta ili upravljačke ploče hostinga.

Ako niste sigurni kako prenijeti datoteku, obratite se svom web hostu i on bi vam trebao pomoći.

Testirajte svoju datoteku robots.txt

Nakon što prenesete datoteku robots.txt na svoje web mjesto, sljedeći je korak da je testirate kako biste bili sigurni da radi ispravno. Google nudi besplatni alat pod nazivom robots.txt Tester u Google Search Consoleu koji možete koristiti za testiranje svoje datoteke. Može se koristiti samo za robotske .txt datoteke koje se nalaze u korijenskom direktoriju vaše web stranice.

Da biste koristili robots.txt tester, unesite URL vaše web stranice u robots.txt tester alat i zatim ga testirajte. Google će vam tada pokazati sadržaj vaše datoteke robots.txt kao i sve pogreške koje je pronašao.

Koristite Googleovu Open-Source Robots Library

Ako ste iskusniji programer, Google također ima biblioteku robota otvorenog koda koju možete koristiti za upravljanje datotekom robots.txt lokalno na vašem računalu.

Što se može dogoditi sa SEO-om vaše web stranice ako je datoteka robots.txt neispravna ili nedostaje?

Ako je vaša datoteka robots.txt neispravna ili nedostaje, to može uzrokovati indeksiranje stranica koje ne želite da budu indeksirane. To na kraju može dovesti do rangiranja tih stranica na Googleu, što nije idealno. To također može rezultirati preopterećenjem stranice jer alati za indeksiranje pokušavaju indeksirati sve na vašoj web stranici.

Datoteka robots.txt koja je neispravna ili nedostaje također može uzrokovati da tražilice za indeksiranje propuste važne stranice na vašoj web stranici. Ako imate stranicu za koju želite da bude indeksirana, ali je blokirana neispravnom ili nedostajućom datotekom robots.txt, možda nikada neće biti indeksirana.

Ukratko, važno je provjeriti radi li vaša datoteka robots.txt ispravno i nalazi li se u korijenskom direktoriju vaše web stranice. Riješite ovaj problem stvaranjem novih pravila ili učitavanjem datoteke u svoj korijenski direktorij ako nedostaje.

Najbolji postupci za datoteke Robots.txt

Sada kada znate osnove datoteka robots.txt, prođimo kroz neke najbolje prakse. Ovo su stvari koje biste trebali učiniti kako biste bili sigurni da je vaša datoteka učinkovita i radi ispravno.

Koristite novi redak za svaku direktivu

Kada dodajete pravila svojoj datoteci robots.txt, važno je koristiti novi redak za svaku direktivu kako biste izbjegli zbunjivanje tražilica za indeksiranje. Ovo uključuje pravila Dopusti i Zabrani.

Na primjer, ako želite onemogućiti alatima za indeksiranje weba da indeksiraju vaš blog i vašu kontakt stranicu, dodajte sljedeća pravila:

Disallow: /blog/

Disallow: /kontakt/

Koristite zamjenske znakove za pojednostavljenje uputa

Ako imate mnogo stranica koje želite blokirati, dodavanje pravila za svaku može biti dugotrajno. Srećom, možete koristiti zamjenske znakove da pojednostavite svoje upute.

Zamjenski znak je znak koji može predstavljati jedan ili više znakova. Najčešći zamjenski znak je zvjezdica (*).

Na primjer, ako želite blokirati sve datoteke koje završavaju na .jpg, dodajte sljedeće pravilo:

Disallow: /*.jpg

Koristite “$” za određivanje kraja URL-a

Znak dolara ($) još je jedan zamjenski znak koji možete koristiti za određivanje kraja URL-a. Ovo je korisno ako želite blokirati određenu stranicu, ali ne i stranice koje dolaze nakon nje.

Na primjer, ako želite blokirati stranicu s kontaktima, ali ne i stranicu s uspješnim kontaktom, dodajte sljedeće pravilo:

Disallow: /kontakt$

Koristite svaki korisnički agent samo jednom

Srećom, kada dodajete pravila svojoj datoteci robots.txt, Google nema ništa protiv ako koristite isti korisnički agent više puta. Međutim, smatra se najboljom praksom koristiti svaki korisnički agent samo jednom.

Koristite specifičnost kako biste izbjegli nenamjerne pogreške

Kada su u pitanju datoteke robots.txt, specifičnost je ključna. Što ste precizniji u svojim pravilima, manja je vjerojatnost da ćete napraviti pogrešku koja bi mogla naštetiti SEO-u vaše web stranice.

Koristite komentare da ljudima objasnite svoju datoteku robots.txt

Unatoč vašim datotekama robots.txt koje indeksiraju botovi, ljudi će ih i dalje morati moći razumjeti, održavati i upravljati njima. To je osobito istinito ako na vašoj web stranici radi više ljudi.

Svojoj datoteci robots.txt možete dodati komentare kako biste objasnili što određena pravila rade. Komentari moraju biti u svom retku i započeti s #.

Na primjer, ako želite blokirati sve datoteke koje završavaju na .jpg, možete dodati sljedeći komentar:

Disallow: /*.jpg #Blokiraj sve datoteke koje završavaju na .jpg

To bi pomoglo svima koji trebaju upravljati vašom datotekom robots.txt da razumiju čemu pravilo služi i zašto postoji.

Koristite zasebnu datoteku robots.txt za svaku poddomenu

Ako imate web stranicu s više poddomena, najbolje je izraditi zasebnu datoteku robots.txt za svaku. To pomaže da stvari budu organizirane i olakšava tražilicama da razumiju vaša pravila.

Uobičajene pogreške datoteke Robots.txt i kako ih popraviti

Razumijevanje najčešćih pogrešaka koje ljudi rade sa svojim datotekama robots.txt može vam pomoći da ih sami ne napravite. Ovdje su neke od najčešćih pogrešaka i kako popraviti te tehničke probleme sa SEO-om .

Nedostaje datoteka robots.txt

Najčešća pogreška u datoteci robots.txt je da je uopće nema. Ako nemate datoteku robots.txt, pretraživači će pretpostaviti da im je dopušteno indeksirati cijelu vašu web stranicu.

Da biste to popravili, morat ćete izraditi datoteku robots.txt i dodati je u korijenski direktorij svoje web stranice.

Datoteka Robots.txt nije u imeniku

Ako nemate datoteku robots.txt u korijenskom direktoriju svoje web stranice, tražilice je neće moći pronaći. Kao rezultat toga, pretpostavit će da im je dopušteno indeksirati cijelu vašu web stranicu.

To bi trebao biti jedan naziv tekstualne datoteke koja se ne smije nalaziti u podmapama, već u korijenskom direktoriju.

Nema URL-a Sitemapa

Datoteka robots.txt uvijek treba sadržavati poveznicu na kartu web-lokacije. To pomaže alatima za indeksiranje tražilica da pronađu i indeksiraju vaše stranice.

Izostavljanje URL-a karte web-mjesta iz datoteke robots.txt uobičajena je pogreška koja možda neće štetiti SEO-u vaše web-lokacije, ali njegovo dodavanje će ga poboljšati.

Blokiranje CSS-a i JS-a

Prema Johnu Muelleru, morate izbjegavati blokiranje CSS i JS datoteka jer Google pretraživači traže od njih da ispravno prikazuju stranicu.

Naravno, ako botovi ne mogu prikazati vaše stranice, one neće biti indeksirane.

Korištenje NoIndexa u robots.txt

Od 2019. metaoznaka noindex robots je zastarjela i Google je više ne podržava. Zbog toga biste trebali izbjegavati njegovu upotrebu u datoteci robots.txt.

Ako još uvijek koristite noindex robots meta oznaku, trebali biste je ukloniti sa svoje web stranice što je prije moguće.

Nepravilna upotreba zamjenskih znakova

Neispravno korištenje zamjenskih znakova rezultirat će samo ograničavanjem pristupa datotekama i direktorijima koje niste namjeravali učiniti.

Kada koristite zamjenske znakove, budite što precizniji. To će vam pomoći da izbjegnete pogreške koje bi mogle naštetiti SEO-u vaše web stranice. Također, držite se podržanih zamjenskih znakova, odnosno zvjezdice i simbola dolara.

Pogrešna ekstenzija vrste datoteke

Kao što naziv implicira, datoteka robot.txt mora biti tekstualna datoteka koja završava na .txt. To ne može biti HTML datoteka, slika ili bilo koja druga vrsta datoteke. Mora biti izrađen u UTF-8 formatu. Koristan uvodni izvor je Googleov vodič za robot.txt i Google Robots.txt FAQ.

Koristite Robot.Txt datoteke kao profesionalac

Datoteka robots.txt moćan je alat koji se može koristiti za poboljšanje SEO-a vaše web stranice. Međutim, važno ga je pravilno koristiti.

Ako se pravilno koristi, datoteka robots.txt može vam pomoći u kontroli koje će stranice indeksirati tražilice i poboljšati indeksiranje vaše web stranice. Također vam može pomoći da izbjegnete probleme s dvostrukim sadržajem.

S druge strane, ako se neispravno koristi, datoteka robots.txt može učiniti više štete nego koristi. Važno je izbjegavati uobičajene pogreške i slijediti najbolje postupke koji će vam pomoći da iskoristite puni potencijal svoje datoteke robots.txt i poboljšate SEO vaše web stranice. Sada možete dopustiti brže indeksiranje, brže vrijeme odgovora i ukupno bolje korisničko iskustvo.

13

lis 2023

U ovom okruženju digitalnog marketinga koji se brzo razvija, otkrio sam da je ključ uspjeha ostati informiran o promjenama koje slijede. Budući da optimizacija za tražilice (SEO) još uvijek drži titulu u podizanju online vidljivosti i pokretanju organskog prometa, uspon umjetne inteligencije (AI) postao je prekretnica u industriji.

13

lis 2023

Tehnički SEO je dobro izvedena strategija koja uzima u obzir različite signale rangiranja na stranici i izvan nje kako bi se vaša web stranica rangirala više u SERP-ovima. Svaka SEO taktika igra veliku ulogu u poboljšanju ranga vaše stranice osiguravajući da alati za indeksiranje weba mogu lako indeksirati i rangirati vašu web stranicu.

19

sij 2023

U 2022. tržište e-trgovine vrijedilo je više od 5 trilijuna dolara, a internetska prodaja brzo se povećala.